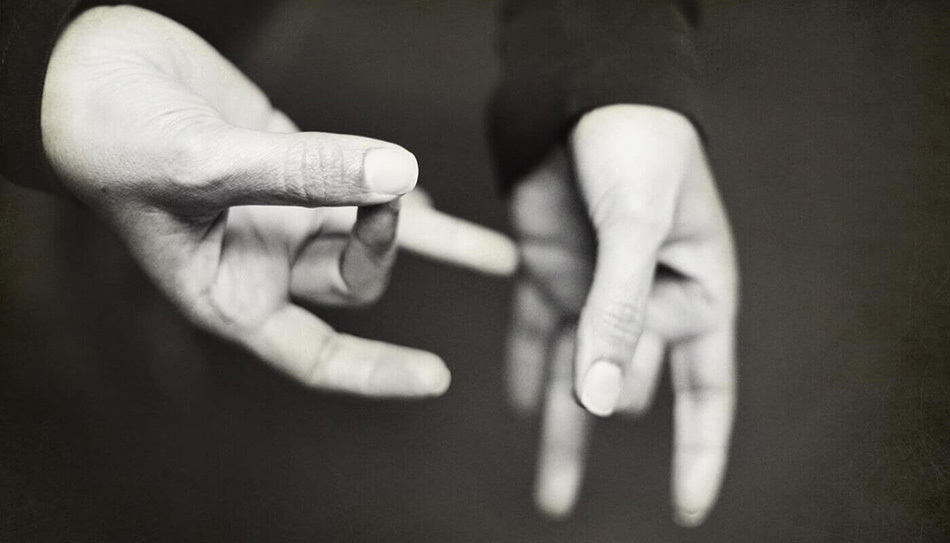

Исследователи Санкт-Петербургского Федерального исследовательского центра Российской академии наук (СПб ФИЦ РАН) научили нейросеть распознавать несколько десятков слов русского жестового языка на основе анализа видео. Разработка будет способствовать повышению качества жизни людей с ограниченными возможностями и позволит глухим людям удобно взаимодействовать с различными видами техники.

Сегодня в мире насчитывается несколько сотен миллионов человек, которые страдают проблемами со слухом, и это количество ежегодно увеличивается. В частности, в России проживает более 13 млн людей с нарушением слуха, в том числе более 1 млн — дети. Для общения эти люди используют специальный язык жестов, который различается в зависимости от стран и диалектов. Этот фактор усложняет такой большой социальной группе возможность использования цифровых помощников, управляемых голосом, на смартфонах, компьютерах и других системах, которые сейчас активно внедряются в различные сферы жизни.

Однако машинный перевод с жестовых языков сегодня сопряжён с большими сложностями по сравнению с обработкой звучащих языков благодаря дополнительной задаче распознавания динамических жестов. В числе причин, которые сдерживают развитие этого направления, такие проблемы компьютерного зрения, как различия в фоновом освещении, необходимость привлечения больших вычислительных ресурсов, недостаточный объём наборов данных.

«Мы разработали систему, которая способна с помощью нейросети распознавать более 50 жестов русского жестового языка. Эта работа направлена на то, чтобы люди с нарушением или потерей слуха могли наладить взаимодействие с компьютерами, цифровыми помощниками наравне со всеми остальными пользователями», — рассказывает Дмитрий Рюмин, старший научный сотрудник Санкт-Петербургского института информатики и автоматизации РАН (СПИИРАН — входит в СПб ФИЦ РАН).

Нейросеть для обучения использует жесты глухих людей, которые фиксировались на видеозаписи. На основе этих данных создавались трёхмерные модели, на которых система с помощью алгоритмов глубокого машинного обучения училась распознавать определённые жесты. В качестве респондентов в исследовании участвовали студенты и преподаватели Межрегионального центра реабилитации лиц с проблемами слуха города Павловска. Всего в учреждении для исследования было отснято более 3 тыс. видеозаписей.

«Мы испытали нейросеть в лабораторных условиях. Для этого был создан прототип специальной роботизированной тележки для супермаркетов, на которой разместились камера и портативный компьютер с программным обеспечением для распознавания жестов. Глухой человек на языке жестов объяснял, зачем он пришёл в магазин, а тележка вела его к месту, где лежит нужный покупателю товар. На выборке жестов, которую мы использовали для обучения, точность распознавания составила более 90%», — поясняет Дмитрий Рюмин.

Проект реализован в 2018-2020 гг. в ходе Федеральной целевой программы совместно с учеными из Чехии. Сейчас ученые СПб ФИЦ РАН выиграли грант Российского научного фонда для продолжения исследований по данной тематике. В течение 2021-2023 года планируется значительно увеличить объём данных для повышения точности распознавания русского жестового языка.

Источник: Берза